Fraude impulsionada por IA generativa: detecção, prevenção e o futuro da gestão de riscos

A natureza da fraude mudou – passou da automação baseada em regras para modelos adaptativos capazes de aprender e evoluir. A IA generativa trouxe uma nova camada de complexidade, tornando o comportamento fraudulento mais realista e adaptável aos sistemas de detecção. Para as instituições financeiras, isso exige uma mudança rumo à prevenção orientada por inteligência – sistemas capazes de identificar padrões de risco mesmo quando as interações do usuário são simuladas.

Este artigo analisa em profundidade a fraude com IA generativa: como funciona, como detectá-la e o que esperar nos próximos anos. Ele apresenta orientações estratégicas e estruturas aplicadas para ajudar as organizações a enfrentar riscos emergentes por meio de tecnologias avançadas de detecção.

A IA generativa abrange uma variedade de táticas e modalidades, cada uma utilizando conteúdo sintético para enganar sistemas ou pessoas. Entender essas variantes é o primeiro passo para uma defesa eficaz.

Uma das categorias mais visíveis é a fraude habilitada por deepfakes. Criminosos geram áudios, vídeos ou trocas de rosto de pessoas reais – celebridades, executivos corporativos ou até indivíduos comuns – para dar legitimidade a solicitações fraudulentas.

Os invasores podem usar chamadas de vídeo geradas por IA para se passar por um diretor financeiro sênior, instruindo funcionários a aprovar transferências urgentes ou liberar dados confidenciais de clientes. As conversas parecem autênticas em tom e movimento, muitas vezes apoiadas por modelos de voz deepfake treinados com gravações públicas.

As chamadas ao vivo com deepfakes representam uma ameaça ainda maior: os criminosos podem participar de reuniões de vídeo, incluindo imitação de voz, tentando enganar funcionários para autorizar transferências ilícitas ou divulgar credenciais de acesso.

Os modelos generativos (LLMs) elevaram o phishing a um novo patamar. Em vez de mensagens vagas ou mal escritas, os ataques modernos são contextuais, personalizados e redigidos em tom fluente.

Ao mesmo tempo, identidades sintéticas – criações completas de personalidade, credenciais e histórico – são produzidas com ferramentas de IA e usadas para passar por verificações de identidade ou abrir contas de crédito. Essas falsificações estão mais difíceis de distinguir de candidatos “reais” do que nunca antes.

Em vez de um operador humano enviando e-mails ou fazendo chamadas individualmente, os criminosos agora utilizam agentes baseados em LLM que planejam campanhas, gerenciam diálogos e respondem aos usuários em tempo real.

Esses agentes conseguem simular conversas fraudulentas de múltiplas etapas, com estratégias de persuasão realistas e modulação emocional – capacidades que tornam a engenharia social escalável.

Em muitas operações, os fraudadores combinam supervisão humana com ferramentas de IA. Eles podem usar IA para gerar roteiros de identidade ou dados biométricos falsos e, em seguida, inserir intervenção humana onde a lógica adaptativa é necessária. Essa estrutura híbrida permite explorar os pontos fortes da IA enquanto compensa suas limitações.

Em fraudes de longo prazo – conhecidas como investment grooming ou “pig butchering” – os criminosos cultivam a confiança da vítima durante semanas ou meses antes de monetizar o golpe.

A automação impulsionada por IA permite que os fraudadores mantenham interações fraudulentas prolongadas, simulando sinais de confiança e confirmações fabricadas.

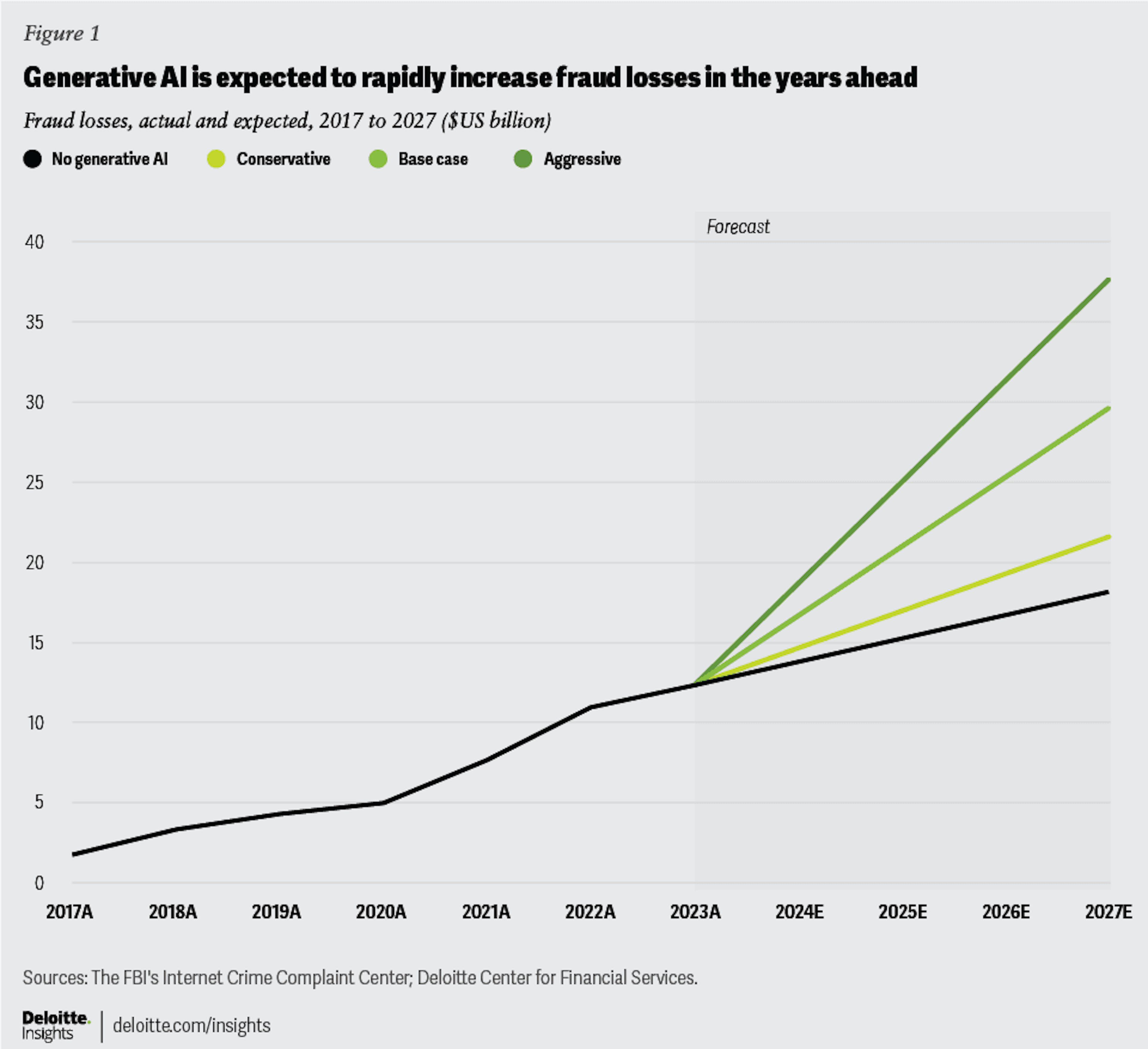

A escala é alarmante. Apenas nos Estados Unidos, estima-se que a fraude com IA generativa atinja 40 bilhões de dólares até 2027, segundo o Deloitte Center for Financial Services.

As tentativas de fraude com deepfakes aumentaram 3.000% em 2023 em comparação com o ano anterior. A América do Norte se tornou o principal alvo, com um aumento aproximado de 1.740% nos casos relatados de fraude com deepfakes entre 2022 e 2023. O impacto financeiro continua crescendo – apenas no primeiro trimestre de 2025, as perdas na região ultrapassaram 200 milhões de dólares. A região da Ásia-Pacífico segue uma tendência semelhante, com um aumento anual de cerca de 1.530% em fraudes relacionadas a deepfakes. Esse crescimento acelerado evidencia como a IA generativa tem amplificado as operações de fraude em uma velocidade sem precedentes.

Para se proteger contra a fraude impulsionada por IA generativa, é preciso ir além da verificação estática e adotar sistemas adaptativos e ricos em dados. Métodos tradicionais de verificação – como o escaneamento de documentos ou a checagem biométrica – têm limitações quando confrontados com identidades sintéticas ou geradas por IA.

Juntas, essas abordagens permitem que as instituições financeiras reconheçam não apenas os dados apresentados na superfície, mas a verdadeira natureza da entidade por trás da tela.

Como a IA generativa pode produzir voz, vídeo, imagem e texto sintéticos, as defesas devem avaliar criticamente cada tipo de mídia e realizar verificações cruzadas:

A IA generativa pode reproduzir texto ou imagens com alta precisão, mas ainda tem dificuldade em imitar o ritmo humano e a diversidade natural de comportamento.

A análise comportamental ajuda a identificar essa diferença ao examinar micro-padrões de interação: movimentos do cursor, velocidade de rolagem, pressão de toque, tempo de permanência na página ou ritmo de digitação e de transições na tela.

Enquanto os dados comportamentais revelam como uma entidade age, a inteligência de dispositivos identifica de onde ela age.

Essa camada é especialmente poderosa contra fraudes impulsionadas por IA e identidades sintéticas, em que os identificadores tradicionais do usuário estão ausentes ou foram manipulados.

Embora os processos tradicionais de KYC possam ser suscetíveis à manipulação, a inteligência de dispositivos fornece uma camada técnica confiável que reflete sinais genuínos de comportamento e ambiente. Ela se torna o elo que conecta padrões sintéticos entre diferentes identidades e períodos de tempo.

A fraude evolui por imitação; a defesa deve evoluir por retroalimentação.

Mesmo com a automação mais avançada, a supervisão especializada continua essencial.

Analistas revisam casos ambíguos, supervisionam escalonamentos e garantem que o processo de decisão permaneça transparente e responsável. Os modelos de defesa mais eficazes combinam a precisão da IA com o julgamento humano e controles de conformidade claros – criando um equilíbrio em que a automação aprimora a precisão sem substituir a responsabilidade.

Ferramentas sofisticadas de fraude estão se tornando produtos comerciais. Deepfake-as-a-service, geradores de roteiros de conversação e kits de identidade sintética são vendidos abertamente na dark web, reduzindo a barreira de entrada para o crime organizado.

Pesquisas como ScamAgent mostram que LLMs podem simular chamadas fraudulentas de múltiplas etapas com lógica persuasiva. Com o avanço da clonagem de voz e da modulação emocional, veremos o surgimento de operações de fraude totalmente autônomas.

Criminosos treinarão seus modelos para contornar detectores, forçando os defensores a implementar ciclos de reentrenamento adversarial. Essa dinâmica de “IA contra IA” definirá a próxima era da prevenção de fraudes digitais.

Devem surgir definições legais mais claras para identidade sintética e engano baseado em IA, além de exigências de transparência, padrões de marca d’água e trilhas de auditoria obrigatórias para conteúdo generativo.

As táticas de fraude se expandirão cada vez mais entre os ecossistemas de crédito, pagamentos e seguros, exigindo colaboração mais próxima entre instituições financeiras, reguladores e provedores de tecnologia.

A fraude com IA generativa deixou de ser um fenômeno isolado e se tornou um desafio mensurável e crescente em todo o ecossistema digital.

Na JuicyScore, ajudamos organizações a fortalecer sua avaliação de risco por meio de inteligência de dispositivos e análise comportamental com foco em privacidade (privacy-first), revelando padrões ocultos que nenhum modelo generativo consegue mascarar.

Agende uma demo e descubra como nossa tecnologia identifica comportamentos sintéticos, detecta ambientes virtualizados e possibilita decisões mais rápidas, inteligentes e seguras.

É uma forma de engano em que fraudadores usam modelos generativos – LLMs, deepfakes ou identidades sintéticas – para se passar por pessoas reais ou criar perfis falsos com fins financeiros.

Cada vez mais. Agentes de IA conseguem conduzir conversas simultâneas, adaptar-se ao usuário e até gerenciar links de pagamento – tornando a escala uma ameaça maior do que nunca.

Combinando inteligência de dispositivos, análise comportamental e perícia de mídia – verificando não apenas o que o usuário mostra, mas como e de onde ele age.

Porque ela revela o ambiente real por trás da interação. Mesmo que uma persona gerada por IA pareça legítima, a impressão do dispositivo, os sinais do sistema ou a continuidade da sessão geralmente revelam que se trata de um ambiente sintético ou virtualizado.

O comportamento humano em nível micro – movimentos do cursor, ritmo de digitação, pausas naturais e mudanças de contexto – que sistemas generativos não conseguem reproduzir de forma autêntica.

O que é fraude em pagamentos? Descubra os principais tipos, táticas e estratégias de prevenção em 2026. Guia para bancos, fintechs, BNPL e instituições de crédito digital.

Explore como a inteligência de dispositivos aprimora a detecção de fraudes, o credit scoring e o onboarding – com análise em tempo real e design centrado na privacidade.

Descubra como credores digitais em microfinanças podem detectar fraudes em tempo real, reduzir riscos e proteger carteiras e clientes usando inteligência avançada de dispositivos, análise comportamental e muito mais.