Fraude impulsado por IA generativa: detección, prevención y el futuro de la gestión de riesgos

La naturaleza del fraude ha cambiado: pasó de la automatización basada en reglas a modelos adaptativos capaces de aprender y evolucionar. La IA generativa ha introducido un nuevo nivel de complejidad, haciendo que el comportamiento fraudulento parezca más realista y se adapte mejor a los sistemas de detección. Para las instituciones financieras, esto implica un cambio hacia una prevención basada en la inteligencia — sistemas capaces de identificar patrones de riesgo incluso cuando las interacciones del usuario son simuladas.

Este artículo analiza en profundidad el fraude con IA generativa: cómo funciona, cómo detectarlo y qué se puede esperar a continuación. Ofrece una guía estratégica y marcos aplicados para ayudar a las organizaciones a enfrentar los riesgos emergentes mediante tecnologías avanzadas de detección.

La IA generativa abarca una amplia gama de tácticas y modalidades, cada una de ellas aprovechando contenido sintético para engañar a sistemas o personas. Comprender sus variantes es el primer paso hacia una defensa efectiva.

Una de las categorías más visibles es el fraude habilitado por deepfakes. Los atacantes generan audios, videos o imitaciones con rostros intercambiados de personas reales — celebridades, directivos corporativos o incluso individuos particulares — para otorgar legitimidad a operaciones fraudulentas.

Los estafadores pueden utilizar videollamadas generadas por IA para hacerse pasar por un director financiero de alto nivel e instruir a empleados a aprobar transferencias urgentes o divulgar información confidencial. Las conversaciones parecen auténticas tanto en tono como en movimiento, respaldadas por modelos de voz entrenados con grabaciones públicas.

Las videollamadas en vivo con deepfakes representan una amenaza aún mayor: los atacantes pueden participar directamente en reuniones virtuales, imitando la voz y la apariencia de otra persona con el fin de engañar a empleados y obtener credenciales de acceso o autorizar transferencias ilícitas.

Los modelos generativos (LLMs) han llevado el phishing a una nueva dimensión. En lugar de mensajes vagos o mal redactados, los ataques actuales son contextuales, personalizados y redactados con un tono fluido y convincente.

Al mismo tiempo, las identidades sintéticas — creaciones completas de personalidad, documentos y historiales — se elaboran con herramientas de IA para superar procesos de verificación o abrir cuentas de crédito. Estas falsificaciones son hoy más difíciles de distinguir de los solicitantes reales que nunca.

Ya no se trata de operadores humanos que envían correos o hacen llamadas una por una. Los atacantes ahora implementan agentes basados en LLM que pueden planificar campañas, gestionar diálogos y responder en tiempo real.

Estos agentes son capaces de mantener conversaciones persuasivas, con tono emocional adaptable y estrategias realistas de manipulación, haciendo que la ingeniería social sea escalable.

En muchas operaciones, los delincuentes combinan supervisión humana con herramientas de IA. Pueden usar IA para generar guiones de identidad o datos biométricos falsos, e intervenir manualmente donde se requiere lógica adaptativa. Esta estructura híbrida les permite aprovechar las fortalezas de la IA y compensar sus limitaciones.

En estafas a largo plazo — conocidas como grooming financiero o “pig butchering” — los estafadores desarrollan una relación de confianza con la víctima durante semanas o meses antes de ejecutar la estafa.

La automatización impulsada por IA les permite sostener interacciones fraudulentas prolongadas, simulando señales de confianza y confirmaciones falsas.

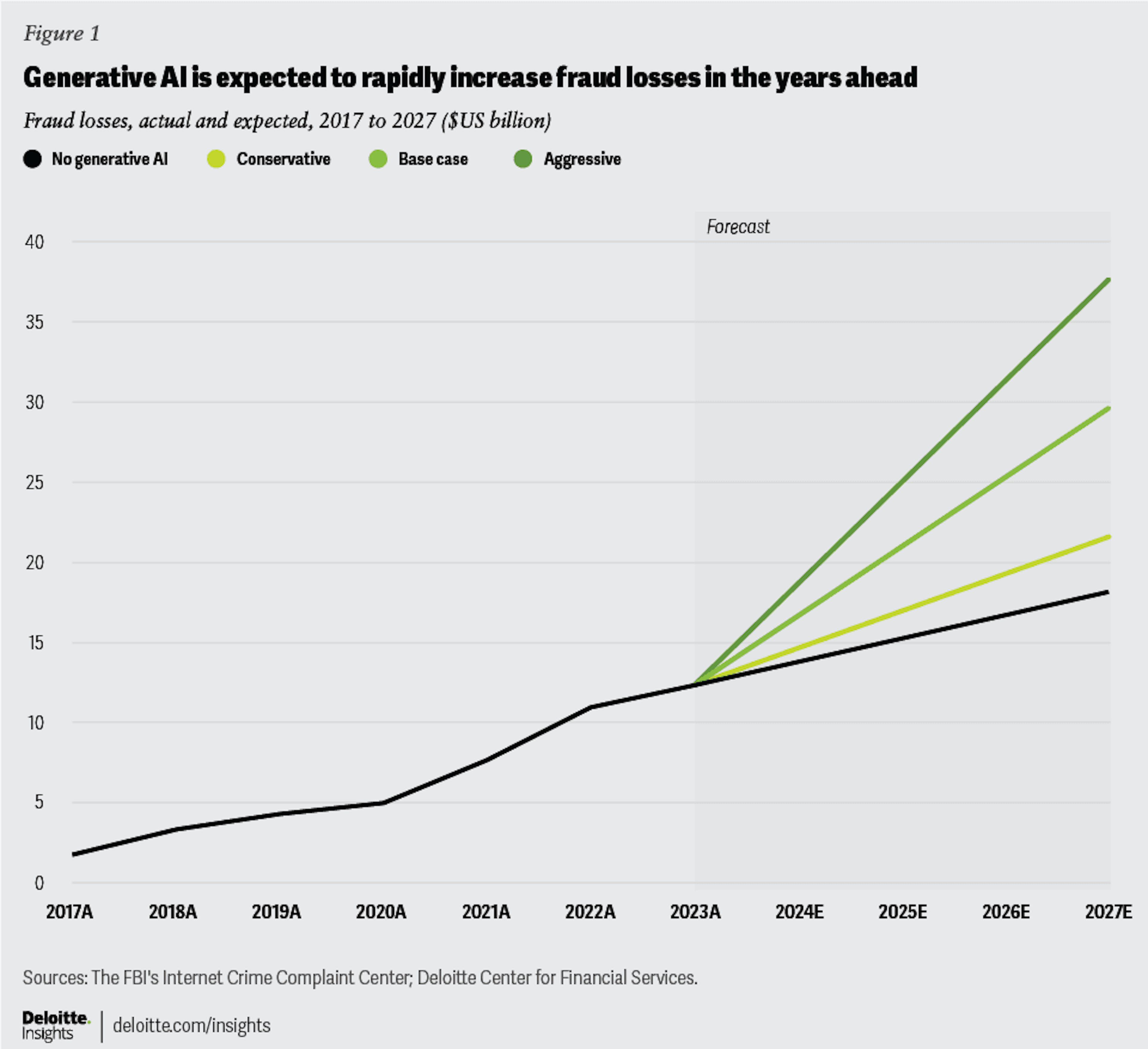

La magnitud es alarmante: solo en Estados Unidos, se espera que el fraude con IA generativa alcance los 40 mil millones de dólares para 2027, según el Deloitte Center for Financial Services.

Los intentos de fraude con deepfakes aumentaron un 3.000% en 2023 en comparación con el año anterior. América del Norte se ha convertido en el principal objetivo, con un aumento de aproximadamente 1.740% en los casos de fraude con deepfakes entre 2022 y 2023. El impacto financiero sigue creciendo: solo en el primer trimestre de 2025, las pérdidas en la región superaron los 200 millones de dólares. La región de Asia-Pacífico muestra una tendencia similar, con un incremento interanual cercano al 1.530% en los fraudes relacionados con deepfakes. Este crecimiento acelerado evidencia cómo la IA generativa ha amplificado las operaciones de fraude a una escala sin precedentes.

Defenderse del fraude impulsado por la IA generativa requiere ir más allá de la verificación estática y adoptar sistemas adaptativos y ricos en datos. Los métodos tradicionales de verificación –como el escaneo de documentos o los controles biométricos– tienen limitaciones frente a identidades sintéticas o generadas por IA.

En conjunto, estos métodos permiten a las instituciones financieras reconocer no solo los datos que se muestran en la superficie, sino la verdadera naturaleza de la entidad que está detrás de la pantalla.

Dado que la IA generativa puede producir voz, video, imagen y texto sintéticos, las defensas deben evaluar cada medio de forma crítica y verificar su coherencia entre sí:

La IA generativa puede reproducir texto o imágenes con gran precisión, pero tiene dificultades para imitar el ritmo y la diversidad natural del comportamiento humano.

La analítica de comportamiento ayuda a detectar esta diferencia mediante el análisis de micro-patrones de interacción: movimientos del cursor, velocidad de desplazamiento, presión de toque, tiempo de permanencia o ritmo de escritura y navegación.

Mientras los datos de comportamiento revelan cómo actúa una entidad, la inteligencia de dispositivos identifica desde dónde lo hace.

Esta capa es especialmente poderosa frente al fraude impulsado por IA o identidades sintéticas, donde los identificadores tradicionales del usuario pueden estar ausentes o manipulados.

Mientras los procesos tradicionales de KYC pueden ser manipulables, la inteligencia de dispositivos ofrece una capa técnica confiable que refleja señales genuinas del entorno y del comportamiento. Se convierte en el tejido conector que une patrones sintéticos a través de diferentes identidades y periodos de tiempo.

El fraude evoluciona mediante la imitación; la defensa debe evolucionar mediante la retroalimentación.

Incluso con la automatización más avanzada, la supervisión experta sigue siendo esencial.

Los analistas revisan casos ambiguos, supervisan las escalaciones y garantizan que la toma de decisiones siga siendo transparente y responsable. Estas capas técnicas forman la base, pero el componente humano sigue siendo indispensable. Los modelos de defensa más sólidos combinan la precisión de la IA con el juicio humano y controles de cumplimiento claros –creando un equilibrio donde la automatización mejora la exactitud sin reemplazar la responsabilidad–.

Las herramientas sofisticadas de fraude se están volviendo productos comerciales. Servicios de deepfake, generadores de guiones conversacionales y kits de identidad sintética se venden abiertamente en mercados del dark web, reduciendo la barrera de entrada para el crimen organizado.

Investigaciones como ScamAgent demuestran que los LLM pueden simular llamadas fraudulentas de múltiples turnos con lógica persuasiva. A medida que mejora la integración con clonación de voz y modulación emocional, se prevé la aparición de operaciones de fraude totalmente autónomas.

Los atacantes entrenarán sus modelos para evadir los detectores, lo que obligará a los defensores a implementar ciclos de reentrenamiento adversarial. Esta dinámica de “IA contra IA” definirá la próxima era de la prevención del fraude.

Se esperan definiciones legales más claras sobre identidad sintética y engaño basado en IA, junto con requisitos de transparencia, normas de marca de agua y mandatos de trazabilidad para el contenido generativo.

Las tácticas de fraude se expandirán cada vez más entre los ecosistemas de crédito, pagos y seguros, impulsando una colaboración más estrecha entre instituciones financieras, reguladores y proveedores tecnológicos.

El fraude con IA generativa ha pasado de casos aislados a un desafío medible y creciente en los ecosistemas digitales.

En JuicyScore, ayudamos a las organizaciones a fortalecer su evaluación de riesgo mediante inteligencia de dispositivos y analítica de comportamiento bajo un enfoque privacy-first, que revela patrones ocultos que ningún modelo generativo puede enmascarar.

Agende una demo hoy para descubrir cómo nuestra tecnología identifica comportamientos sintéticos, detecta entornos virtualizados y permite decisiones más rápidas, inteligentes y seguras.

Es una forma de engaño en la que los estafadores utilizan modelos generativos –LLMs, deepfakes o identidades sintéticas– para hacerse pasar por personas reales o crear identidades falsas con fines financieros.

Cada vez más. Los agentes de IA pueden gestionar múltiples conversaciones simultáneas, adaptarse al usuario e incluso manejar enlaces de pago, haciendo que la escala sea una amenaza mayor que nunca.

Mediante la combinación de inteligencia de dispositivos, analítica de comportamiento y análisis forense de medios –verificando no solo lo que el usuario muestra, sino cómo y desde dónde actúa–.

Porque revela el entorno real detrás de la interacción. Incluso si una persona generada por IA parece legítima, la huella del dispositivo, las señales del sistema o la continuidad de la sesión suelen delatar que es sintética o virtualizada.

El comportamiento humano a nivel micro –movimientos del cursor, ritmo de escritura, pausas naturales o cambio de contexto– que los sistemas generativos no pueden reproducir de forma auténtica.

Descubra cómo la inteligencia de dispositivos mejora la detección de fraude, el scoring crediticio y la incorporación – con análisis en tiempo real y enfoque en la privacidad.

Descubra cómo los prestamistas digitales en microfinanzas pueden detectar fraudes en tiempo real, reducir riesgos y proteger carteras y prestatarios mediante inteligencia avanzada de dispositivos, análisis de comportamiento y más.

¿Qué es el fraude en pagos? Descubra los principales tipos, tácticas y cómo prevenirlo en 2026. Guía para bancos, fintechs, BNPL y prestamistas digitales.